TECH & AI

เร้ดแฮทส่งRed Hat AI Inference Serverปลดล็อกนำGenerative AI

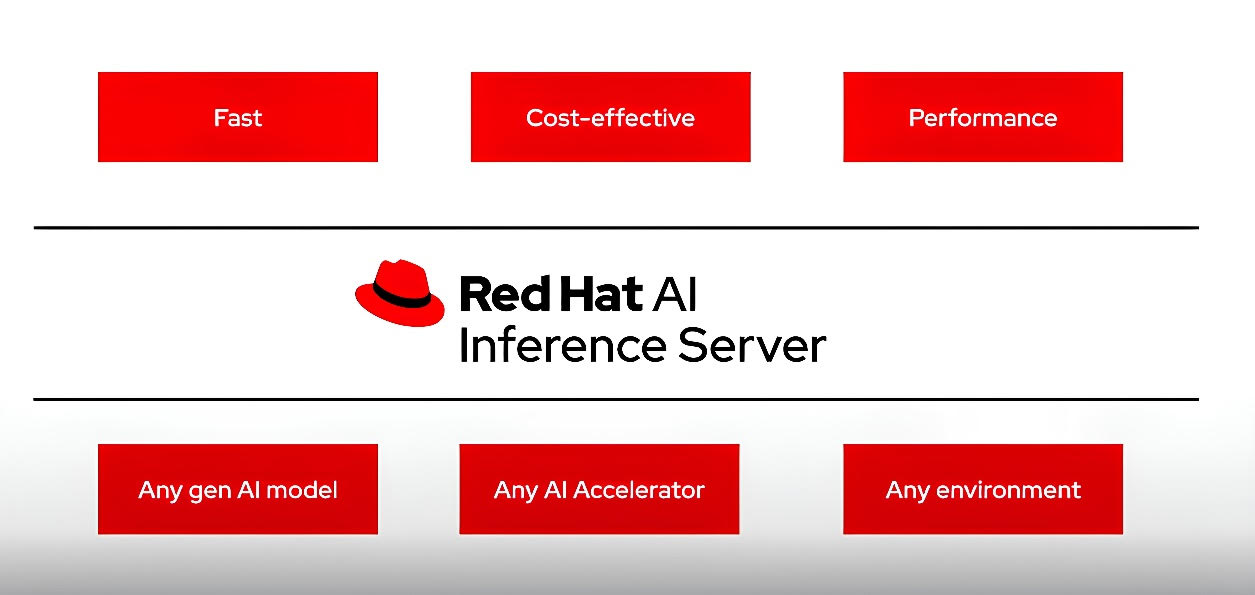

กรุงเทพฯ วันที่ 5 มิถุนายน 2568 – เร้ดแฮท ผู้ให้บริการโซลูชันโอเพ่นซอร์สชั้นนำของโลก ประกาศเปิดตัว Red Hat AI Inference Server ก้าวสำคัญที่จะทำให้ generative AI (gen AI) กลายเป็นเทคโนโลยีที่ใครก็ใช้ได้บนไฮบริดคลาวด์ทุกแห่ง โซลูชันใหม่นี้นำเสนออยู่ใน Red Hat AI เป็นเซิร์ฟเวอร์อนุมานระดับองค์กรที่เกิดจากโปรเจกต์จาก vLLM community อันทรงพลัง และเร้ดแฮทเพิ่มประสิทธิภาพด้วยการผสานรวมเข้ากับเทคโนโลยี Neural Magic ทำให้มีความเร็วมากขึ้น ช่วยเพิ่มประสิทธิภาพให้ accelerator และคุ้มค่าใช้จ่าย เป็นการตอบวิสัยทัศน์ของเร้ดแฮทในการมอบการใช้งานโมเดล gen AI ใด ๆ บน AI accelerator ใด ๆ ก็ได้ บนทุกสภาพแวดล้อมคลาวด์ แพลตฟอร์มที่ล้ำหน้านี้ช่วยให้องค์กรต่าง ๆ ใช้และสเกล gen AI สู่การทำงานเป็นรูปธรรมได้อย่างมั่นใจมากขึ้น ไม่ว่าจะใช้งานแบบสแตนด์อโลน หรือผสานเป็นส่วนประกอบของ Red Hat Enterprise Linux AI (RHEL AI) และ Red Hat OpenShift AI ก็ตาม

การอนุมานเป็นเครื่องมือทำงานที่สำคัญของ AI โดยโมเดลที่ผ่านการเทรนล่วงหน้าจะแปลงข้อมูลให้เป็นการใช้งานในสถานการณ์จริง ซึ่งเป็นจุดสำคัญของการปฏิสัมพันธ์กับผู้ใช้ ที่ต้องการการตอบสนองอย่างฉับไวและแม่นยำ การที่โมเดล gen AI ทั้งหลายขยายตัวอย่างรวดเร็วตามขนาดการใช้งานจริงและมีความซับซ้อน ทำให้การอนุมาน (inference) อาจกลายเป็นคอขวดที่เป็นอุปสรรคสำคัญ สิ้นเปลืองทรัพยากรฮาร์ดแวร์ และเป็นเหตุให้การตอบสนองไม่มีประสิทธิภาพ ทั้งยังทำให้ค่าใช้จ่ายในการดำเนินงานเพิ่มขึ้น ดังนั้น เซิร์ฟเวอร์การอนุมานที่มีประสิทธิภาพแข็งแกร่งไม่ใช่สิ่งฟุ่มเฟือยอีกต่อไป แต่เป็นสิ่งจำเป็นที่จะช่วยปลดล็อกให้ได้ใช้ศักยภาพที่แท้จริงของ AI ในวงกว้าง และการใช้งานที่ง่ายขึ้นอย่างมากจะช่วยขจัดความซับซ้อนที่ซ่อนอยู่ได้

เร้ดแฮทเจาะจงจัดการความท้าทายเหล่านี้ด้วย Red Hat AI Inference Server ซึ่งเป็นโซลูชันการอนุมานแบบโอเพ่นที่ออกแบบมาเพื่อมอบประสิทธิภาพที่สูง มีเครื่องมือบีบอัดและเพิ่มประสิทธิภาพโมเดลที่มีประสิทธิภาพชั้นนำติดตั้งมาพร้อม นวัตกรรมนี้ช่วยเสริมให้องค์กรใช้สมรรถนะของ gen AI ได้อย่างเต็มที่ด้วยการมอบประสบการณ์การตอบสนองที่ดีขึ้นอย่างมากให้กับผู้ใช้ และผู้ใช้มีอิสระในการเลือกใช้ AI accelerators เลือกใช้โมเดลและสภาพแวดล้อมไอทีได้ตามต้องการ